Saison 1 (3/3) - L’ordinateur : 30 000 fois plus rapide qu’en 1946, mais toujours aussi stupide

- Macada

- 15 juil. 2025

- 8 min de lecture

Dernière mise à jour : 4 sept. 2025

Explorer les possibilités réelles de production des IA, c’est très vaste, alors, idée ! existe-il un goulot d’étranglement qui limite leurs capacités, et dont il serait plus facile d’appréhender le fonctionnement exact ?

La réponse est : oui ! Ce sont des machines qui exécutent les programmes. L’IA ne peut donc pas faire plus que ce que peut faire un ordinateur.

C’est pourquoi, cette première saison de « L’ordinateur, l’IA et le cerveau » se focalise sur la notion d’ordinateur.

Il y a 3 noix :

- l’introduction de la saison qui cerne les questions à se poser : S1.1 Peut-on définir un ordinateur comme une 2CV ?

- la définition théorique d’une machine : S1.2 L’ordinateur : une machine à écrire dans tous ses états

- la réalité technique d’une machine (ci-dessous) : S1.3 Le temps et les pannes n’existent pas pour les machines, mais pour les humains, si !

S1.3 : Le temps et les pannes n'existent pas pour les machines, mais pour les humains, si !

Résumé de l'épisode précédent : Un ordinateur est une machine physique qui a la même puissance de représentation qu’une machine de Turing (ou de tout autre modèle de calculabilité) et la même puissance de calcul.

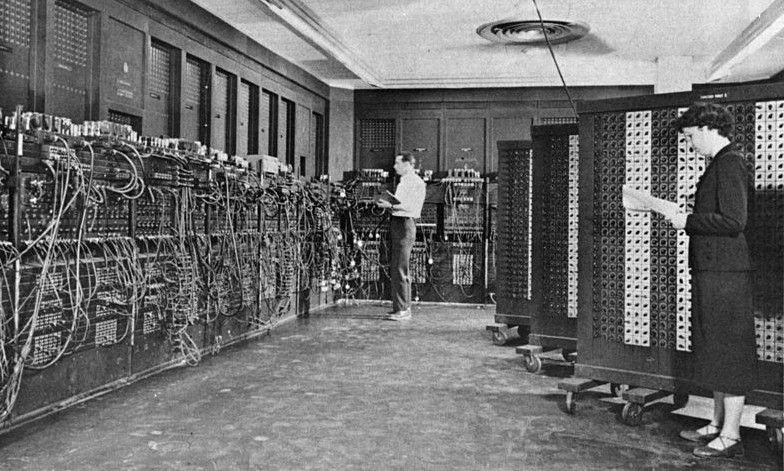

Le calculateur reconnu comme le premier ordinateur jamais construit est l’ENIAC (pour Electronic Numerical Integrator Analyser and Computer, IBM et US army), dans sa version de 1946.

Son architecture physique est établie à partir de la machine de Turing, le modèle de calculabilité exposé dans l’épisode précédent. Notez que la machine théorique était au point en 1936, mais qu'il a fallu 10 ans pour matérialiser le premier ordinateur y correspondant entièrement. (Et profitons-en pour rendre hommage aux « 3 John », qui l’ont conçu : le mathématicien et physicien John von Neumann (1903-1957) et les physiciens John William Mauchly (1907-1980) et John Eckert (1919-1995).)

Noisette : Contrairement à ce que raconte le film « Imitation Game » (2014) sur la vie de Turing, ni la machine physique de décryptage des codes allemands qu’il a aidé à construire pendant la seconde guerre mondiale ni Enigma, la machine allemande qui générait les dits codes, n’étaient assez puissantes en calcul pour mériter le nom « d’ordinateur ». C’en était presque, mais pas tout à fait.

(Mais c’est bien Alan Turing qui a inventé la machine théorique à son nom en 1936, hein !).

Depuis 1946, TOUS les ordinateurs - y compris les quantiques - ont EXACTEMENT la même puissance de représentation et de calcul que le premier ordinateur.

C’est là que vous vous exclamez : « Hein ! quoi ! mais les ordinateurs d’aujourd’hui sont bien plus puissants que ceux d’hier ! »

En quelque sorte.

Sauf que ce n’est pas leur définition qui a changé, ce sont les techniques de fabrication qui se sont améliorées et permettent un usage concret plus étendu. C’est l’éternel problème de la réalisation en pratique d’une fabrication sur plans. En l'occurrence, je le répète : il a fallu 10 ans pour construire le premier ordinateur y correspondant entièrement ! Et depuis 80 ans que les composants matériels des machines évoluent, il y a toujours des problèmes résolvables (ouaip, j’ai dit : « résolvables », « solubles », ça fait trop bizarre) théoriquement par la machine qui ne le sont pas dans les faits.

Premier bémol de la matérialisation physique : les pannes

Les machines physiques tombent en panne un jour où l’autre (voire plusieurs fois par jour) : pas glop, si le programme à exécuter est très long et qu’il est interrompu par un « bug » qui exige de tout recommencer.

Noisette : Le terme « bug » désignant une erreur dans l’exécution d’un programme signifie « bestiole » en anglais. Il provient des insectes qui, en se brûlant aux ampoules des premiers ordinateurs électroniques (c’étaient des machines « à lampes », pas « à puces » comme aujourd’hui), les faisaient griller, provoquant des pannes ou des erreurs dans les résultats.

Noisette : Si les ordinateurs utilisent dans les tréfonds de leurs processeurs seulement deux caractères (le rond/0 et le bâton/1) et pas l’alphabet latin ou le code ASCII (les 256 caractères d’un clavier), c’est d’une part parce qu’un alphabet à 2 caractères suffit pour coder tous les « mots » de n’importe quel autre alphabet (ce qui arrive d’un clavier est traduit en binaire avant d’être traité par le processeur ou mis en mémoire). Et d’autre part, parce que c’est du courant alternatif qui représente physiquement les caractères : intensité faible, c’est le rond, intensité forte, c’est le bâton. Or, il est très coûteux, voire hors de portée technique même actuellement, d’assurer un courant alternatif assez stable pour pouvoir être « découpé » en 26 ou 256 plages d’intensités différentes ; la moindre variation électrique involontaire fait passer un caractère pour un autre. Historiquement, on a tenté le codage décimal pour les premiers ordinateurs, mais les erreurs étaient légions, c’est pourquoi les ingénieurs ont vite adopté le binaire au niveau physique.

Second bémol du monde physique : la 4ème dimension

Contrairement à un modèle de calculabilité dans lequel le temps est infini/n’existe pas, le temps des humains est compté. À quoi leur servirait une machine qui met un an, un siècle, des millénaires, ou l’âge de l’univers, pour exécuter un programme ?

Or, il y a beaucoup de problèmes qui peuvent être résolus par calcul mais qui demandent un nombre faramineux de lire/écrire/se déplacer d’un caractère à la fois. (« faramineux », c’est de l’ordre de milliards de milliards de milliards de calculs, ou beaucoup plus.).

Par exemple, à la fin du siècle dernier, l’analyse automatique (on dirait IA, maintenant ;-)) des données météo pour prédire précisément le temps à 7 jours demandait environ… 3 semaines. Mais les algorithmes étaient bons : le temps calculé était presque aussi souvent advenu réellement que les prévisions des experts (qui, eux, avaient mis 1 ou 2 heures pour les estimer à partir des mêmes données). La rapidité des calculs ayant grandement augmenté, le même algorithme de prévision met désormais quelques minutes à être exécuté (et le boulot des experts, maintenant, c’est de corriger ou re-critériser les calculs pour diminuer la marge d’erreur).

Troisième bémol du monde physique : le stockage limité

Tous les murs de votre chez vous sont désormais isolés par deux couches de livres papier, et, comme vous ne pouvez pas vous empêcher d’acheter de nouveaux ouvrages, il ne vous reste plus d’autres choix que de déménager dans un plus grand appart' ? Lisez donc en numérique ! (;-))

Eh bien, il fut un temps où les programmes et leur résultats étaient stockés sur des fiches cartonnées perforées (un trou = rond, pas de trou = bâton), et ça prenait des armoires et des armoires pour le moindre programme et ses données. Impossible de gérer de grosses masses d’informations, les deux mémoires d’un ordinateur - celle du processeur - dite « vive » ou « éphémère » - pour le calcul en cours et ses données-opérandes, et celle, dite « dure », de stockage et sauvegarde des données - étaient trop limitées physiquement pour cela.

Il a fallu développé tout un tas de nouvelles technologies pour que la réalité physique - et économique - soit enfin comparable en pratique aux capacités d’une mémoire théorique - infinie - d’un modèle de calculabilité ( le « ruban » d’écriture/lecture d’une Machine de Turing - sa mémoire - n’a pas de limites de stockage).

Les électroniciens et autres physiciens ont plutôt bien relevé les défis, non ?

Ainsi, ce sont les obstacles physiques et économiques à la réalisation pratique d’un ordinateur théorique qui sont peu à peu franchis depuis 1946 : la fiabilité, la rapidité, la capacité de mémoire (et la taille), et le coût.

Des technologies électromécaniques des premiers grands calculateurs, on est passé à l’électronique à lampes (inventée en 1907), environ 400 fois plus rapide, puis à l’électronique à transistors (1956-63), puis aux circuits intégrés (1963-71), puis aux micro-processeurs (puces) toujours d’actualité.

Les technologies de stockage - les mémoires - ont suivi, tandis que la taille des machines et leur coût chutaient dans les mêmes proportions.

Le moindre de nos petits ordinateurs individuels est au moins 30 000 fois plus rapide que les premiers, peut contenir des médiathèques entières, se glisse dans un petit sac à main - ou une poche -, et est à portée de bourse d’une partie conséquente de la population mondiale (désolée, je n’ai pas trouvé de chiffres probants sur le nombre de foyers équipés, mais les Nations Unies affirment qu’Internet - et donc des ordinateurs - est accessible à 2/3 de la population mondiale).

Bien évidemment, beaucoup de problèmes théoriquement programmables en 1946 le sont aussi désormais en pratique. Leurs résolutions exigent toujours le même nombre de calculs de base (= d’opérations lire, écrire, se déplacer de 1 caractère) mais que chacun s’exécute en 1/30 000ème de seconde plutôt qu’en 1 seconde change sacrément la donne. Idem, entre une mémoire inerte qui contient 1 livre versus une mémoire qui contient des dizaines de milliers de livres (au moins !) : les programmes d’analyses et de fouilles d’un grand nombre de données sont utiles quotidiennement.

L’informatique, et notamment l’algorithmique – la conception de la suite d’instructions permettant de résoudre un problème informatisable – se sont donc développées en fonction des possibilités des ordinateurs.

Noisette : D’où vient le mot « algorithmique » ? Éthymologiquement, de « algo », la douleur (comme dans « névralgie »), et de « rythme », la musique . La musique de la douleur, quoi !… Nan, je déc**ne.

Il n’y a pas de « y » dans algorithme parce que le mot vient du nom du mathématicien perse (probablement originaire de l'actuel Ouzbekistan) : Al-Khwârizmî (vers 780-vers 850), considéré comme le père de l’algèbre. Eh oui, le calcul formel et les suites d’instructions que sont les algorithmes relèvent de l’algèbre, discipline mathématique que le sergent Côlon dans « Va-t-en-guerre » de Terry Pratchett définit avec une justesse indéniable par : « L'algèbre, c'est comme des additions avec des lettres. C'est pour ceux qu'ont pas assez de cervelle pour les nombres. »

En conclusion de cette saison de noix :

En 2025, l’ordinateur est au moins 30 000 fois plus rapide qu’en 1946, beaucoup beaucoup plus petit… mais toujours aussi stupide !

La prochaine saison de « L’ordinateur, l’IA et le cerveau » s’attachera à montrer que nous, les humains, nous sommes de très piètres calculateurs parce que nos capacités cognitives (notre intelligence, si vous voulez) vont bien au-delà du simple traitement calculatoire de suites de caractères. Calculer pour nous, c’est un peu comme vouloir creuser une piscine avec une petite cuiller, alors qu’on dispose d’une pelleteuse.

Sans compter qu’avoir l’idée d’une piscine est tout autant hors de portée des capacités d’un ordinateur que de celles de la petite cuiller.

————————

Références et crédits

Contribution de : Macada (autrice et scientifique. Pour en savoir plus : comme elle est aussi rédac' chef des Noix, sa présentation se trouve : ICI )

Images : US Army (photo ENIAC, 1946), Norfolk Record Office (livraison Elliot 405, 1957), anonyme_CC0 (pour la photo du laptop), Macada

Références dans le texte (ou les images) :

« Un jour, j’irai vivre en Théorie, parce que, en Théorie, tout se passe bien », anonyme, XIXème siècle ou avant (selon Marc Lévy qui a mené l’enquête pour un de ses livres : https://www.liberation.fr/france/2017/02/13/ou-l-on-enquete-avec-marc-levy-sur-une-citation-qui-n-est-pas-de-pierre-desproges_1548218/)

« L'algèbre, c'est comme des additions avec des lettres. C'est pour ceux qu'ont pas assez de cervelle pour les nombres. », dans Va-t-en-guerre, Terry Pratchett, 1997

« 67% de la population mondiale a accès au Net » : « Rapport sur le développement humain 2023-2024 », Programme des Nations Unies sur le Développement humain : https://www.undp.org/sites/g/files/zskgke326/files/2024-10/hdr23_full_report_0319_fr_v2_0.pdf

Pour les autres références sur le contenu : une flopée de cours et articles d’universitaires trouvables sur le Net (à noter que les infos sur Wikipédia sont un bon départ de recherches documentaires, mais à recouper par d’autres références sérieuses, notamment en sciences molles (ici, en histoire de l’informatique)).

Commentaires